До чего же может дойти человеческая мысль! Просто ужас порой берет. В общем, решил я покачать всякого интересного с одного известного торрент трекера. Ну что, все так делают, чем я хуже. В общем – пошел на сайт, а он не работает. Вот блин, копирасты, подумал я. Погуглил, нашел слухи о том что сайт по DDOS атакой, и всякие товарищи предложили пойти на ipv6 адрес данного трекера. Сказано – сделано. Но ping сразу, из коробки, не пошел. Я не стал долго думать над решением. Зачем, если сначала проще всего спросить у гугла. И гугл нашел решение. Ну по правде говоря это решение для Win7, но поскольку разница идеологически не очень большая – работать должно. Но меня сразу смутило начало – “Шаг 1. Удаляем весь мусор”. Это просто феерия, накал сами знаете чего! Вот отчего все что там перечислено – мусор? Позвольте поинтересоваться, что оно вообще такое? От чего же оно мусор? НУ и далее по тексту ручное добавление дефолтного маршрута и проблемы из этого вытекающие. Моему возмущению просто нет предела. И после вот такого “конфигурирования” вы хотите чтобы ОС работала как надо?

В общем, единственное что полезно в этой статье – это список teredo серверов и IPv6 DNS. Все остальное можно смело отправить на помойку. К слову, в конфигурации по умолчанию у меня оно таки заработало, позже, после тестов. Не знаю почему, не вникал. Исследование требует времени. Возможно есть некторые проблемы с teredo сервером по умолчанию, а возможно они случились когда я попытался этим воспользоваться. Не могу сказать точно, но в конечном итоге простейшая процедура следующая:

- Указать IPv6 DNS в настройках интерфейса

- Задать сервер teredo, отличный от заданного по умолчанию

- Подождать, пока поднимется туннельный интерфейс. По умолчанию он поднят и настроен, но может статься, что не работает. По разным причинам, тут сниффр в руки и вперед. Правда думается, что во многих случаях будет работать из коробки, и все это нужно проделывать только если не работает.

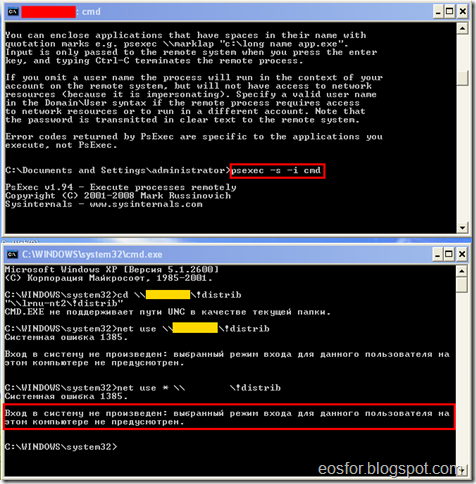

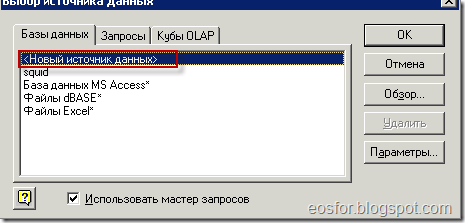

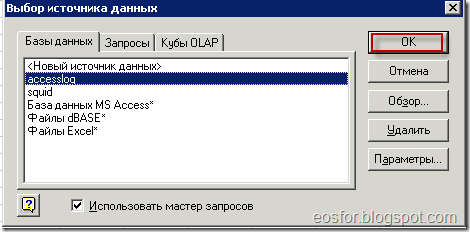

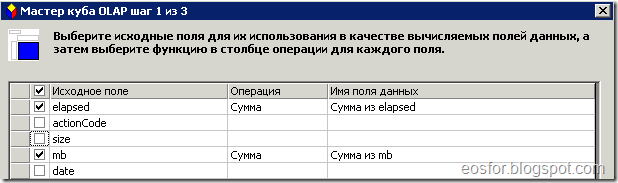

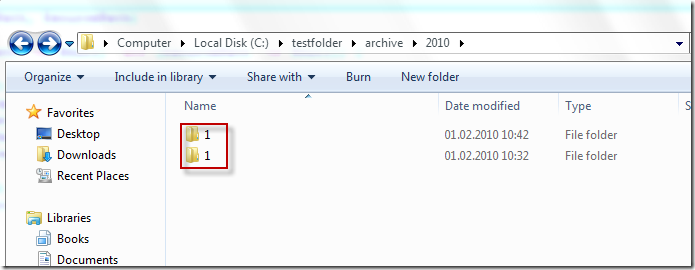

Ну и собственно, картинки:

Настройки сетевого интерфейса

После всего вернул в исходное состояние но все продолжило работать и пинговаться. Возможно нужно было только сказать:

netsh interface teredo set state type= client

или как-то так, чтобы его подергать.

Вывод, читайте документацию, и думайте головой прежде чем что-то удалять!

Взял как бы тут, правда я же это и написал )